Tras una primera publicación al vuelo en redes sociales, donde mi objetivo era dar a conocer un método y contextualizarlo más que exponer una militancia y/o crítica sobre el mismo (mi enfoque/ética sobre la IA es mixta, ya lo he dejado claro), he decidido romper brevemente con el tono habitual de este publicación para configurar una pequeña guía o manual introductorio al "audio poisoning" o "adversarial noise".

Un concepto/tratamiento/táctica que inicialmente descubrí a través de Benn Jordan y que creo representa perfectamente el punto en el que, tanto mis opiniones como mi rol como divulgador, quieren estar: entre la early adoption total (VS el optimismo forzado) y el resentimiento y rechazo absoluto a las nuevas herramientas.

Desde hace años, vivimos en una ficción compartida: la de que publicar música es un acto creativo, cultural o simbólico. Hoy sabemos que publicar música es, también, una forma de donar material para el entrenamiento. Es la era del scraping global. Tu música ya no es simplemente un archivo: es un recurso, una mina abierta a la extracción algorítmica. Plataformas como SUNO, Udio, y sus próximas réplicas devoran el sonido sin pedir permiso y sin rendir cuentas. Los modelos generativos no se alimentan de artistas, sino de datasets.

Se trata de una economía caníbal que se oculta tras los discursos de accesibilidad, comunidad o exposición: una infraestructura invisible y sistemática de expropiación algorítmica. Es el archivo como forma de explotación. Frente a este saqueo digital y artistas resignados sobre la idea de que su música, su trabajo, se use para crear más basura digital y memes efímeros, emerge una respuesta ilusionante: envenenar nuestros audios. Se trata de corromper tu música mediante señales invisibles al oído humano, ruido inteligente diseñado para sabotear el aprendizaje de las IA generativas. No es proteger tu archivo; es codificarlo contra su explotación.

Las opiniones van desde la excesiva racionalización ("bah, repelente de mosquitos"), la ilusión inocente ("cómo pinta esto no???") y el cinismo paranoico ("pero si nada es nuestro ya, esto las IA lo domarán enseguida"). Pero las opiniones aquí no valen una mierda, son las preguntas las que ayudan: ¿Qué consecuencias podría tener a largo plazo esta forma de resistencia? ¿Es una alternativa real? ¿Y si envenenar tu catálogo termina creando una cultura paranoica entre artistas? ¿Podría esta táctica ser rápidamente neutralizada por los grandes modelos? Y la más importante de todas: ¿Es realmente la IA nuestro enemigo, o existe una manera ética y productiva de integrarla en nuestro trabajo?

⚉ Algo de contexto (previo)...

Como este artículo está planteado como una guía, y no como una pieza de opinión, voy a cambiar mi forma de redactar para ser mucho más estructurado, didáctico, obvio y también algo previsible.

→ Advertencias:

- Tus canciones, mezclas, pistas vocales o instrumentales, subidas a Spotify, Bandcamp, SoundCloud, YouTube, e incluso a servicios privados, pueden estar siendo scrapeadas sin aviso.

- Empresas con respaldo millonario como SUNO, Udio, Stability AI o Meta entrenan modelos generativos de música con estos archivos, sin pedir permiso, sin ofrecer compensación, y sin garantizar trazabilidad.

- Estos modelos luego producen música sintética que reutiliza arreglos, timbres, estructuras y decisiones compositivas reales, sin reconocer el origen humano del material.

→ Más contexto previo sobre el scraping algorítmico...

- 2015 – U-Net y su crucial visión computacional: fue un modelo inicialmente concebido para segmentar imágenes biomédicas y que introduce una arquitectura de codificadores-decodificadores con skip connections que permite trabajar con inputs de baja resolución y obtener salidas coherentes. Aunque no nace para el audio, abre la puerta a modelos que leen espectrogramas como si fueran imágenes, y por tanto, a convertir sonidos en datasets funcionales. El oído se vuelve ojo y el sonido en forma.

- 2016 – Google lanza Magenta: se presenta como un proyecto de código abierto para explorar el cruce entre arte e IA, ofreciendo herramientas experimentales: un piano que improvisa contigo, un sintetizador coral, un modelo de transformación de voz. Pero en su backend, lo que hace es otra cosa: escanea millones de archivos musicales, aprende de ellos, y genera variaciones basadas en patrones existentes.

- 2016 – 'Daddy's Car': se promociona como la primera canción generada con IA, pero realmente está compuesta, cantada y producida por humanos. Solo la melodía inicial fue sugerida por una IA entrenada con The Beatles. El caso ilustra una estrategia que será recurrente en años posteriores (y hoy en día): inflar el rol de la IA para vender innovación, invisibilizando el trabajo humano.

- 2019 – OpenAI, ByteDance y la aceleración: OpenAI lanza MuseNet, ByteDance compra Jukedeck. Comienza el desembarco de grandes capitales en el sector. Aparecen las primeras herramientas comerciales de generación musical al vuelo.

- 2023-2024 – SUNO, Udio, Stability: estas empresas entrenan sus modelos con archivos tomados de Spotify, YouTube, SoundCloud, repositorios de librerías digitales, audiolibros y stems instrumentales.

→¿Qué significa “entrenar” en este contexto?

Entrenar no es una acción neutral. Supone, valga la redundancia, desvincular el estilo de su contexto, el gesto de su autoría, de su experiencia. Es convertir la estética en fórmula, y la diferencia en insumo replicable. Por eso hablamos de expolio: se trata de un modelo de captura.

⚉ "Audio poisoning" a.k.a. "Adversarial noise"

La mejor definición que puedo manejar ahora mismo: una forma de resistencia técnica de baja intensidad, una especie de hacking acústico que desafía la narrativa del uso justo y la innovación inevitable. No es una técnica nueva. Pero su aplicación contra modelos de IA generativa lo convierte en algo distinto: una forma de interferencia deliberada cuyo objetivo no es crear, sino confundir al enemigo. Podemos pensar también en un hongo: no protege directamente, quiere corromper desde dentro.

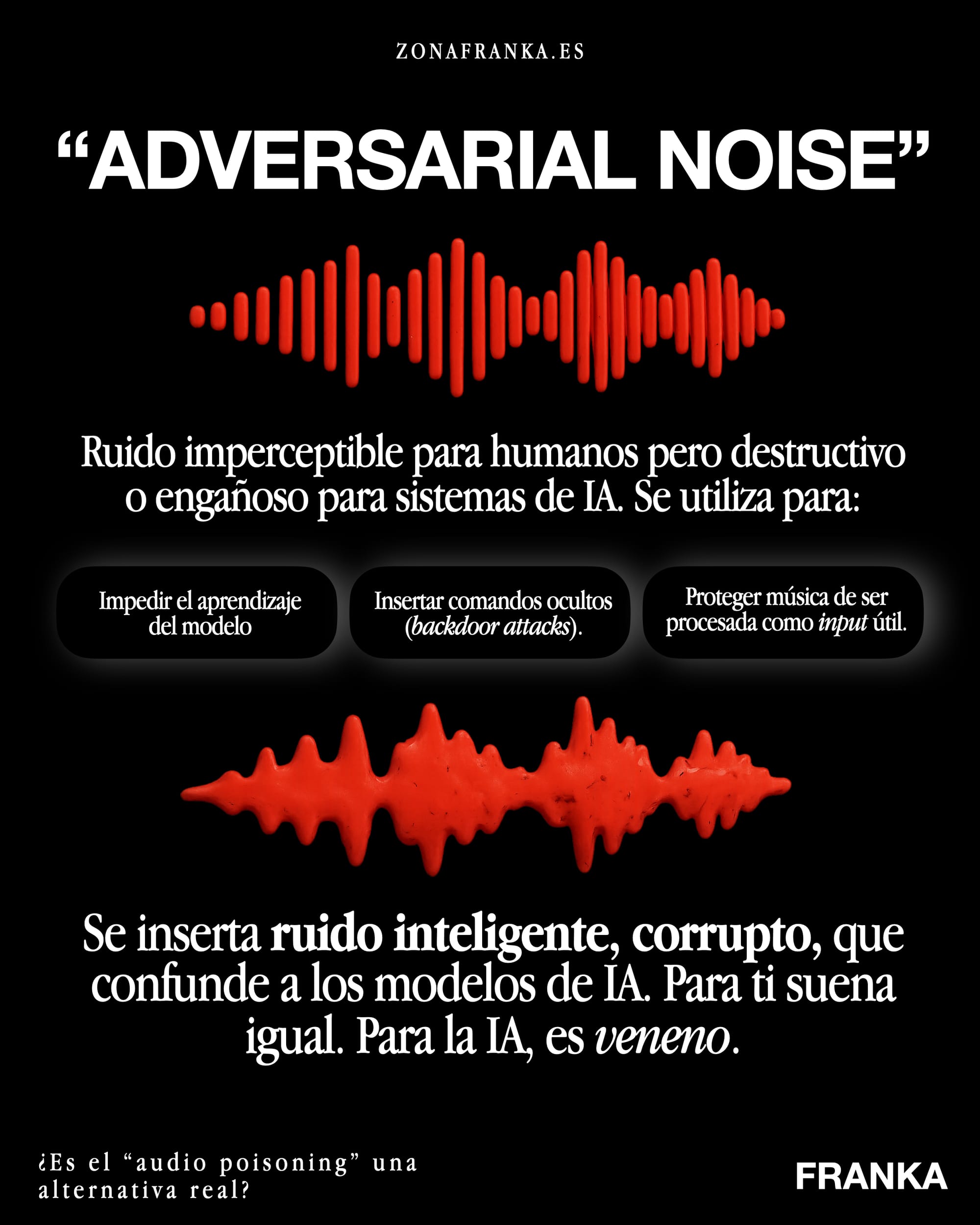

→¿Qué es exactamente el "adversarial noise"?

Una técnica basada en la inserción de ruido inaudible o casi inaudible para el oído humano, pero que altera la forma en que los sistemas de IA interpretan el sonido. Este proceso envenena sus capas internas: el espectrograma, la huella tímbrica, la estructura melódica. Su lógica se basa en explotar las debilidades del aprendizaje automático: pequeños cambios que, al escalarse, pueden inducir errores sistemáticos en los modelos.

→→ ¿Cómo actúa sobre los modelos?

Los modelos generativos no escuchan como los humanos: ven espectros (lol), reconocen densidades, buscan correlaciones. Cuando un modelo aprende de datos contaminados: extrae falsos patrones, repite errores en las generaciones futuras y puede llegar a degradar progresivamente la calidad del output. De alguna manera es como debilitar la memoria del modelo.

→→ ¿Se escucha?

La mayoría de las veces, no. O se percibe como un matiz de textura residual. En términos de publicación, es casi indistinguible del archivo original para un oyente medio.

→→ Tipos y formas de envenenamiento:

- "Poisonify": modifica los timbres y características espectrales de los instrumentos y engaña a los clasificadores de instrumentos (ejemplo: hace que un ride suene como un violín). Además, aplica interferencias que desvían el reconocimiento de patrones.

- Harmony Cloak: deforma estructuras rítmico-melódicas sin afectar la percepción humana y sabotea directamente la comprensión de patrones armónicos y de tempo.

- Ataques combinados: si usamos ambos métodos a la vez, el efecto se multiplica. El archivo sigue sonando limpio, pero se vuelve anti-entrenable.

Esto hace del audio poisoning una herramienta, a simple vista, altamente subversiva: su lógica general es la de reintroducir la fricción en un sistema diseñado para la fluidez. Pero obviamente, no es todo leche lo que sabe a grasa.

⚉ "No es protección, es sabotaje".

La idea de protección parte siempre del miedo. El audio poisoning no pretende conservar o blindar nada. No se aferra al archivo, lo quiere convertir en anomalía. Deja de ser un objeto a preservar y pasa a ser un gesto de interferencia. Una pista puede parecer limpia, funcional, bien ensamblada, pero lleva otra intención. No se limita a sonar: actúa cuando es procesada. No se trata de impedir el uso. Se trata de que usarla tenga consecuencias. Como un caballo de Troya, lo relevante no es lo que parece traer consigo, sino lo que dejará dentro del modelo.

⚉ ¿Un nuevo ludismo algorítmico?

La historia del ludismo suele citarse con una mezcla de paternalismo y advertencia, como si romper máquinas hubiese sido un gesto infantil frente a una modernidad inevitable. Pero el verdadero núcleo de aquel movimiento no estaba en el rechazo a la tecnología, sino en la negativa a aceptar una transformación impuesta sin diálogo ni reparto. Aquellas acciones no defendían un mundo preindustrial, sino una posición simbólica: mostrar que el progreso técnico, cuando se impone sin negociación, no puede llamarse progreso.

El audio poisoning recupera esa misma energía ludita, desplazada al terreno del sonido y del algoritmo. No responde desde la nostalgia, sino desde una inteligencia situada que entiende que no hay marcha atrás, pero sí (algo de) margen para intervenir. El archivo musical deja de ser una pieza pasiva y se convierte en un agente ambiguo que circula con apariencia de normalidad mientras introduce errores que no se anuncian ni se explican.

Si este tipo de sabotaje será duradero o funcional es una pregunta pertinente aunque secundaria. Lo que importa es lo que produce ahora: una fricción en el relato de la inevitabilidad

⚉ ¿Y no existe el riesgo de que el proceso sea neutralizado? ¿Y si el audio envenedado se vuelve deseado?

Todo gesto de sabotaje corre el riesgo de volverse mercancía. Todo gesto táctico puede ser absorbido. La historia reciente está llena de ejemplos: el glitch, el lo-fi, ahora el brain rot, todos nacidos del error, apropiados como estética y convertidos en estilo vendible. El audio poisoning no escapa a esa lógica. Lo que hoy actúa como interferencia técnica podría mañana transformarse en una textura deseada, en marca de autenticidad, en promesa de resistencia sonora hecha plugin. La disidencia, una vez reconocible, es domesticable.

Lo subversivo puede ser neutralizado si no va acompañado de discurso, si no se sitúa con claridad en una posición. Una pista que no puede ser entrenada por la IA puede volverse deseada precisamente por eso, como si el fallo garantizara más autenticidad.

Dicho esto: los modelos de IA pueden adaptarse. Las empresas pueden filtrar. El ludismo fue derrotado. Pero para mí hay cuestiones más importantes ahora mismo: ¿Esto funciona eternamente? Por ejemplo.